A Batalha dos Titãs da IA: Google Apresenta seu Novo Competidor

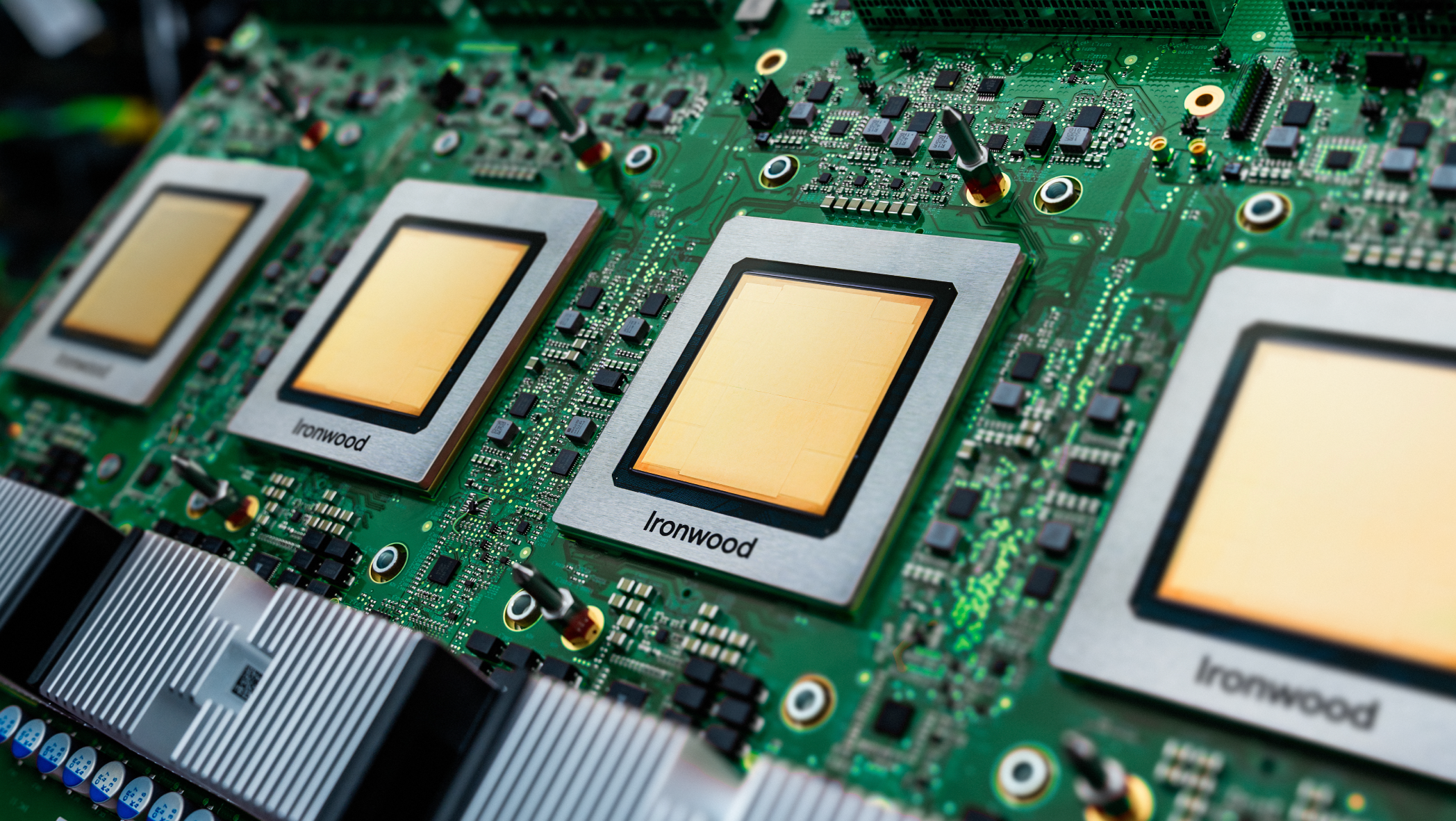

No universo da tecnologia, existem batalhas épicas que definem gerações. Se no passado tivemos a guerra dos navegadores e a disputa dos sistemas operacionais móveis, o campo de batalha de hoje é inegavelmente o dos chips de inteligência artificial. E nesse ringue, o Google acaba de jogar sua mais nova e poderosa carta: a sétima geração de suas Tensor Processing Units (TPUs), batizada com o codinome Ironwood. Previsto para disponibilidade geral nas próximas semanas, o TPU v7 não chega para ser apenas mais um no mercado; ele chega para olhar nos olhos do gigante Blackwell, da Nvidia, e dizer: “temos uma conversa pendente”.

Historicamente, a estratégia do Google com seus TPUs era um pouco diferente. Enquanto a concorrência focava na força bruta de cada chip individual, o Google apostava na força do coletivo, conectando milhares de unidades para compensar o déficit de performance individual. Era uma abordagem de enxame. Com o Ironwood, no entanto, a história muda de figura. O Google não apenas manteve sua lendária capacidade de escala, como também construiu um chip que, individualmente, pode brigar de igual para igual com os melhores do mercado.

Performance de Nivelar o Jogo: Ironwood vs. Blackwell

Vamos aos números, porque é aqui que a conversa fica séria. Segundo uma análise do portal The Register, cada chip Ironwood TPU v7 ostenta impressionantes 4,6 petaFLOPS de desempenho em FP8, um formato de cálculo denso essencial para IA. Esse número não é apenas alto, ele é estrategicamente posicionado um pouco acima dos 4,5 petaFLOPS do B200 da Nvidia. Para alimentar essa fera computacional, o chip vem equipado com 192 GB de memória HBM3e, que entrega uma largura de banda de 7,4 TB/s, números que novamente o colocam no mesmo patamar do concorrente direto da Nvidia.

Essa evolução representa um salto monumental para a arquitetura do Google. A performance do TPU v7 é 10 vezes maior que a do seu antecessor TPU v5p e 4 vezes superior à do TPU v6e. É, sem rodeios, o chip mais potente que a gigante das buscas já criou, encerrando a era em que seus aceleradores eram vistos como menos potentes em uma comparação um-para-um. Agora, o Google tem o melhor dos dois mundos: performance individual de ponta e uma capacidade de escala que continua sendo seu grande diferencial.

O Truque Não é a Força, é o Jeito: A Mágica da Escalabilidade

Se a performance individual do Ironwood o coloca no jogo, é a sua arquitetura de conexão que pode fazê-lo vencer. A verdadeira mágica do Google não está em um único chip, mas na capacidade de conectar dezenas de milhares deles de forma eficiente. Enquanto a Nvidia oferece seu sistema NVL72, que une 72 GPUs Blackwell em um domínio de computação, o Google pensa em uma escala muito, muito maior. Os “pods” de Ironwood podem variar de 256 a impressionantes 9.216 chips interligados.

Como eles fazem isso? Com uma abordagem que lembra a arqueologia da tecnologia, mas com um toque futurista. Em vez de usar switches de pacotes caros e que consomem muita energia, o Google emprega uma topologia de malha tridimensional chamada 3D torus, onde cada chip se conecta a seus vizinhos em três dimensões. Para gerenciar essas conexões, eles usam algo chamado Optical Circuit Switches (OCS). O The Register faz uma analogia perfeita: pense nas antigas centrais telefônicas, onde uma operadora conectava fisicamente uma chamada à outra. O OCS faz algo parecido, criando um caminho físico de luz entre um TPU e outro, o que resulta em latência quase zero. Essa arquitetura não só é eficiente, mas também resiliente: se um chip falhar, o sistema pode simplesmente contorná-lo e substituí-lo por um reserva, sem parar o trabalho.

Clientes de Peso e o Futuro da Guerra Fria da IA

Essa combinação de poder e escala já está dando frutos. Um dos maiores clientes do Google para seus TPUs é a Anthropic, uma das principais desenvolvedoras de modelos de linguagem e concorrente direta do próprio Google com seu modelo Gemini. A Anthropic anunciou planos de utilizar até um milhão de TPUs para treinar e operar suas futuras gerações de modelos Claude. Quando um rival aposta na sua infraestrutura, é sinal de que você está fazendo algo muito certo.

O movimento da Anthropic, que também utiliza a infraestrutura da Amazon, mostra uma tendência no mercado: os grandes desenvolvedores de IA buscam as arquiteturas mais eficientes para treinar modelos gigantescos, e a abordagem de malha em grande escala do Google e da Amazon parece ser a resposta. Enquanto o CEO da Nvidia, Jensen Huang, muitas vezes minimiza a ameaça de chips customizados, é inegável que a capacidade de hardware e a escalabilidade de rede de gigantes como o Google estão se tornando um fator decisivo no mercado.

A chegada do Ironwood TPU v7 solidifica uma nova fase na corrida pela supremacia em IA. A disputa não é mais apenas sobre quem tem o chip mais rápido, mas sobre quem constrói o cérebro digital mais coeso, escalável e eficiente. O Google provou que, além de um gigante do software, é um arquiteto de hardware formidável, e sua aposta em escala pode ser o xeque-mate nesta complexa partida de xadrez tecnológico.

{{ comment.name }}

{{ comment.comment }}