Uma Nova Era de Memória para a Inteligência Artificial

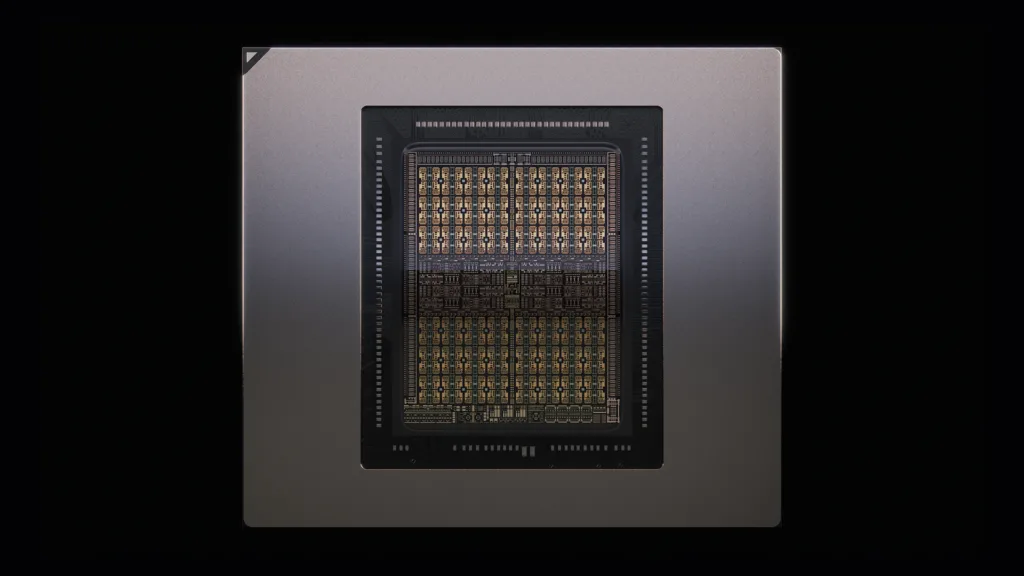

A Nvidia, em seu ritmo implacável de inovação, acaba de apresentar mais uma peça fundamental para o futuro da inteligência artificial. Durante o AI Infrastructure Summit, a empresa anunciou a Nvidia Rubin CPX, uma GPU projetada especificamente para uma tarefa que se torna cada vez mais importante: a inferência de contexto longo. Prevista para chegar ao mercado no final de 2026, esta nova placa de vídeo promete ser o cérebro por trás de IAs capazes de processar sequências de dados com mais de 1 milhão de tokens, um salto monumental para aplicações complexas.

Para colocar em perspectiva, a capacidade da Nvidia de ditar o ritmo do mercado de IA se reflete diretamente em seus resultados financeiros. Conforme destacado no evento, a companhia registrou uma receita de US$ 41,1 bilhões em vendas para data centers em seu último trimestre. A Rubin CPX não é apenas mais um produto nesse portfólio, mas uma aposta estratégica em como a IA irá evoluir, movendo-se de respostas rápidas para compreensões profundas e contextualizadas.

O Poder de um Diálogo Interminável: Entendendo o Contexto Longo

Mas afinal, o que significa uma IA com "contexto longo"? Imagine que você está conversando com um assistente digital. Hoje, muitas vezes ele esquece o que foi dito há poucos minutos. Agora, pense nesse mesmo assistente sendo capaz de ler e lembrar de cada palavra de um livro como 'Guerra e Paz' de uma só vez para discutir a obra com você. Essa é a promessa do contexto longo. A GPU Rubin CPX foi criada para ser a mediadora dessa conversa, a peça de hardware que permite à IA manter um diálogo coerente e profundo, sem perder o fio da meada.

Essa capacidade tem implicações diretas em áreas que demandam uma compreensão holística de grandes volumes de informação. Na geração de vídeo, por exemplo, uma IA poderá criar uma cena complexa lembrando-se de todos os elementos visuais e narrativos apresentados anteriormente. Para desenvolvedores, significa ter um copiloto de programação que entende a totalidade de um projeto de software, sugerindo códigos que se integram perfeitamente a uma base de código de milhões de linhas. A Rubin CPX atua como a ponte diplomática que conecta o início, o meio e o fim de uma gigantesca troca de informações.

A Estratégia da 'Inferência Desagregada': Um Ecossistema de Especialistas

Junto com a nova GPU, a Nvidia introduziu o conceito de "inferência desagregada". Se pensarmos na infraestrutura de IA como um governo, a abordagem tradicional seria ter um único ministro superpoderoso tentando resolver todos os problemas. A inferência desagregada, por outro lado, cria um gabinete de especialistas. Em vez de uma única solução monolítica, a arquitetura é dividida em componentes especializados.

Nesse ecossistema, a Nvidia Rubin CPX é a especialista em diplomacia e memória, focada exclusivamente em processar e entender longas sequências de contexto. Outros componentes do sistema cuidam de diferentes tarefas. Essa especialização cria um sistema muito mais eficiente e escalável. É a interoperabilidade em seu mais alto nível: cada peça do hardware conversa com as outras de forma fluida, construindo uma base robusta onde cada componente faz o que sabe de melhor. É a construção de uma rede de serviços interconectados, em vez de uma única ilha tecnológica.

O Futuro é Conectado e Contextual

A chegada da Rubin CPX, como parte da futura série Rubin, ao final de 2026, reforça a visão da Nvidia de não apenas fornecer força bruta, mas também inteligência arquitetônica para o avanço da IA. A empresa não está vendendo apenas chips; está desenhando o sistema nervoso central para a próxima geração de aplicações inteligentes. A demanda por IAs que não apenas respondem, mas que compreendem e lembram, está crescendo, e a Nvidia está construindo a infraestrutura para tornar essa realidade possível. O anúncio no AI Infrastructure Summit deixa claro que o futuro da inteligência artificial não será sobre a capacidade de processar dados, mas sobre a habilidade de conectá-los de maneira significativa.

{{ comment.name }}

{{ comment.comment }}